خزنده موتور جستجو Crawler چیست؟

خزنده موتور جستجو یا Crawlerها که عنکبوت یا Spider، ربات یا به شکل ساده بات نیز نامیده می شوند، برنامه یا اسکریپت هایی هستند که به شکل سیستمی و خودکار صفحات را بر روی اینترنت مرور می کنند. هدف این مرور خودکار نوعا خواندن صفحاتی است که خزنده موتور جستجو برای افزودن آنها به ایندکس موتور جستجو مرور می کند.

موتورهای جستجو مانند گوگل، از خزنده وب برای خواندن صفحات وب و ذخیره لیستی از کلماتی که در صفحه یافته و جاییکه آن کلمات واقع شدند استفاده می کند. خزنده موتور جستجو داده های اطلاعاتی مانند سرعت و وضعیت خطای HTTP را نیز جمع آوری می کند.

این داده ها در ایندکس موتورهای جستجو – مخصوصا پایگاه داده های بزرگ از صفحات وب ذخیره می شود.

وقتیکه جستجویی را در گوگل صورت می دهید، در واقع در حال جستجو در ایندکس گوگل هستید و نه خود اینترنت. سپس گوگل اقدام به نمایش صفحات ایندکس شده مرتبط با موضوع جستجوی شما کرده و لینک هایی را به صفحات مناسب می دهد.

از آنجاییکه وب مدرن شامل انواع مختلف محتوا است و موتورهای جستجو روش هایی برای جستجو آن نوع مشخص از محتوا دارند، موتورهای جستجوی بزرگ خزنده هایی دارند که مختص خزیدن در فایل ها یا صفحات مشخص هستند. این بخش های به خصوص شامل موارد زیر می شوند:

- محتوای کلی وب

- تصاویر

- ویدیو

- اخبار

- تبلیغات

- موبایل

هر نوع از خزنده عامل کاربری متفاوتی دارد.

خزنده موتور جستجو چگونه عمل می کند؟

از نظر عملی، خزیدن زمانی اتفاق می افتد که یک خزنده آدرسی را برای بررسی پیدا می کند، سپس صفحه را فراخوانده و آن را بر روی یک کامپیوتر محلی ذخیره می کند. شما می توانید همینکار را با رفتن به صفحه و راست کلیک بر روی صفحه و انتخاب گزینه …Save As انجام دهید.

خزنده موتور جستجو نشانی وب را یا با بررسی نقشه سایت دامنه یا با دنبال کردن لینکهایی که در صفحات دیگر وجود دارند دریافت می کند.

Sitemap یا نقشه سایت نقش مهمی در این مرحله ایفا می کند چرا که لیست نشانی های وب سازماندهی شده و جذابی را برای دسترسی به خزنده ارایه می کند. آنها همچنین جزییاتی را ارایه می کنند که بر روش خزیدن خزنده موتور جستجو در هر صفحه تاثیر می گذارد.

بودجه خزیدن چیست؟

صد البته که حتی گوگل هم منابع محدودی دارد (مهم نیست که این محدودیت تا چه اندازه ای است). از این رو Googlebot یا بات های گوگل بر اساس قاعده ای کار می کنند که به عنوان «بودجه خزش» شناخته می شود. بودجه خزش خیلی ساده تعداد نشانی وب بر روی وبسایت است که خزنده موتور جستجوی گوگل می خواهد و می تواند در آن بخزد.

۲ عنصر وجود دارد که بودجه خزش گوگل را برای یک وبسایت مشخص می کند:

- محدودیت نرخ خزش: گوگل نمی خواهد که هنگام خزیدن در وبسایت بر تجربه کاربری وبسایت تاثیر منفی بگذارد بنابراین تعداد صفحاتی که خزنده موتور جستجو می تواند برای یکبار در آنها بخزد محدود است.

- درخواست خزیدن: خیلی ساده بخواهیم بگوییم، خزیدن در گوگل امریست اختیاری که در اختیار خود گوگل قرار دارد! گوگل خیلی علاقه ای به خزیدن در وبسایت هایی ندارد که ارزش افزوده ای برای کاربرانش در پی نداشته باشند (پارامترهای نشانی وب، شناساننده های نشست و …). بنابراین حتی اگر که خزنده موتور جستجو به محدوده نرخ خزش خود هم نرسد، منابعاش را برای صفحات بی ارزش این چنینی هدر نمی دهد.

اما خبر خوب این است که محدوده نرخ خزش و درخواست برای خزیدن بسته به چیزی که گوگل در وبسایت شما می بیند می تواند تغییر پیدا کند. این عوامل بر بودجه خزش وبسایت شما تاثیر می گذارند:

- سرعت سایت: گوگل علاقه ای به انتظار کشیدن ندارد، بنابراین صفحات سریع خزنده موتور جستجو را به خزش بیشتر در صفحات تشویق می کنند. به علاوه سرعت نشانه وبسایت سالم است، بنابراین گوگل قادر به استفاده از منابع بیشتر برای خزیدن خواهد بود.

- صفحات خطا: اگر سرور به درخواست های زیاد گوگل با کدهای خطا پاسخ دهد، اینکار گوگل را از تلاش برای خزیدن در صفحات دلسرد می کند چرا که اینطور به نظر می رسد که با وبسایتی سروکار دارد که با مشکلات زیادی دست و پنجه نرم می کند.

- محبوبیت: هرچه گوگل گمان کند که صفحه شما محبوب تر است، خزنده موتور جستجو به شکل مداوم تر در صفحات وبسایت شما می خزد تا آن را در ایندکس خود بهروز نگاه دارد.

- تازگی: برکسی پوشیده نیست که گوگل به محتوای تازه و بهروز علاقه مند است. انتشار محتوای جدید به گوگل می گوید که وبسایت شما صفحات جدیدی برای خزیدن به شکلی منظم دارد. محتوای تازه تر به معنای خزیدن بیشتر است.

ایندکس جستجو چیست؟

وقتیکه صفحه ای خزیده می شود، گوگل به اطلاعات دقیقی در خصوص صفحه برای ذخیره کردنش در شاخص یا ایندکس خود نیازمند است. موتورهای جستجو از الگوریتم های متنوعی استفاده می کنند تا تعیین کنند که کدام کلمات در محتوای صفحه مهم و مرتبط هستند. افزودن نشانهگذاری معنایی مانند Schema.org به موتورهای جستجو کمک می کند تا درک بهتری از صفحات وبسایت شما داشته باشند.

وقتیکه صفحه ای فراخوانی، ذخیره و تفسیر می شود، اطلاعات استخراج شده از آن در شاخص یا ایندکس موتور جستجو ذخیره می شود. وقتیکه شخصی جستجویی را در موتور جستجو صورت می دهد، اطلاعات درون ایندکس برای تعیین صفحات مرتبط با موضوع جستجو مورد استفاده قرار می گیرند.

چگونه خزیدن گوگل را بهینه سازی کنیم

برای به دست آوردن رتبه بهتر در نتایج جستجو، صفحه بایستی در ابتدا ایندکس شود. برای ایندکس شدن یک صفحه، ابتدا بایستی توسط خزنده موتور جستجو خزیده شود. از این رو قابلیت خزیده شدن اثر بسیار زیادی بر سئو خواهد گذارد.

نمی توانید به شکل مستقیم صفحاتی که خزنده موتور جستجوی گوگل تصمیم به خزیدن می گیرد را کنترل کنید اما می توانید سرنخ هایی را ارایه کند که چه صفحاتی برای خزیدن بهتر است و کدام موارد بایستی نادیده گرفته شوند.

سه روش مهم برای کمک به کنترل مکان، زمان و چگونگی خزیدن صفحات وجود دارد. این موارد قطعی نیستند اما کمک می کنند که مطمئن شویم که مهمترین صفحات توسط خزنده موتور جستجو پیدا می شوند.

نقش Robots.txt

اولین کاری که خزنده موتور جستجو به محض ورود به یک صفحه انجام می دهد باز کردن فایل robots.txt است. اینکار فایل robots.txt را به اولین موقعیت برای معرفی نشانی وب کم ارزش به خزنده موتور جستجو بدل می کند.

می توانید از robots.txt برای معرفی صفحات نالازم برای ایندکس شدن استفاده کنید:

- صفحه تایید سفارش یا تشکر

- محتوای تکراری

- صفحات نتایج جستجوی وبسایت

- صفحات خطا یا محصولات تمام شده

از فایل robots.txt برای عدم اجازه به خزش نشانی های وب مانند جاوا اسکریپت یا CSS استفاده نکنید. خزنده موتور جستجو بایستی از بودجه خزش برای این نشانی های وب استفاده کند و گوگل نیز بایستی قادر به ترجمه کامل یک صفحه برای درک آن به شکل صحیح باشد.

اجتناب از خزش فایل های CSS و JS منجربه خزش و ایندکس مشکلدار و ناقص می شود، در نتیجه، گوگل صفحه را به شکلی متفاوت از انسان دیده و حتی می تواند منجربه سقوط در رتبه بندی گوگل شود.

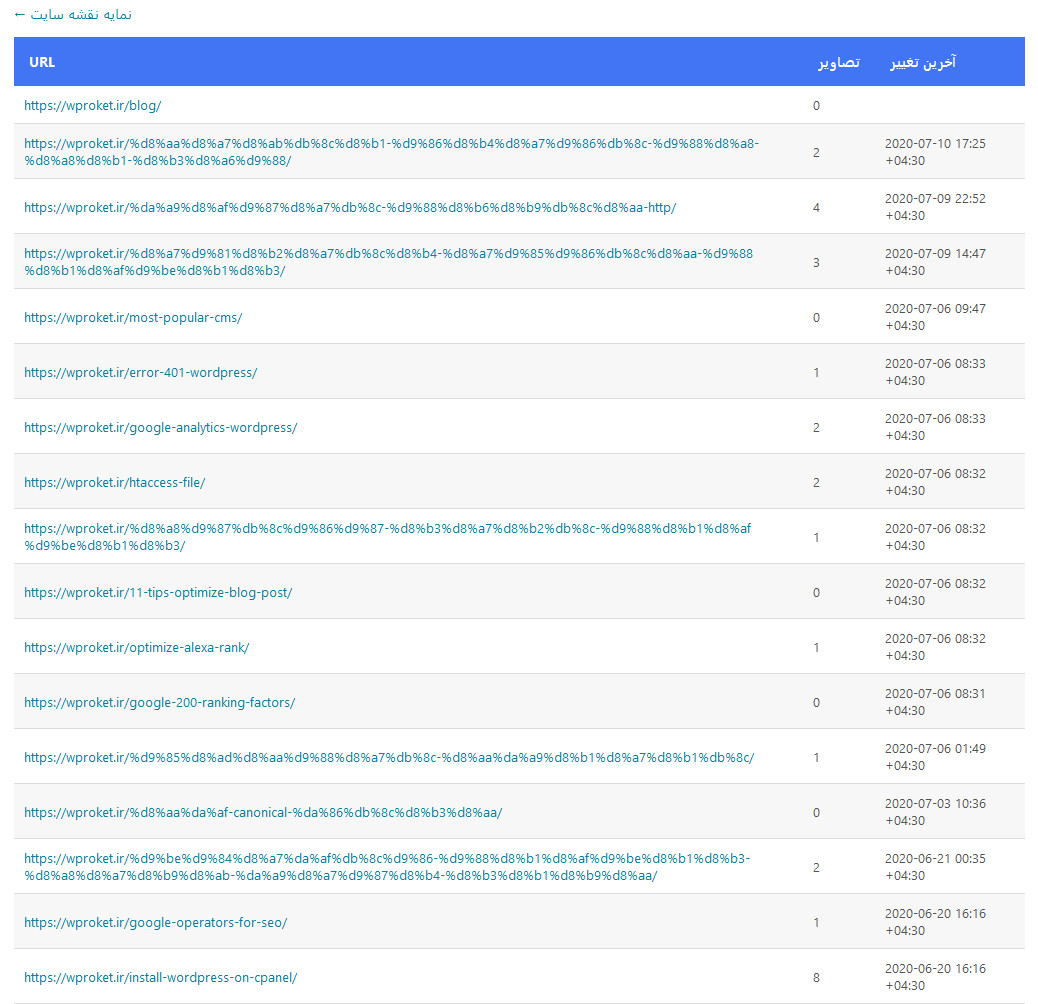

نقش نقشه سایت XML

نقشه سایت XML نقشی کاملا متضاد با robots.txt دارد. این فایل به موتورهای جستجو می گوید که چه صفحاتی را بایستی بخزند. و درحالیکه گوگل تعهدی به خزیدن تمام نشانی های وب در فایل نقشه سایت ندارد (برخلاف robots.txt) می توانید از اطلاعات موجود در صفحات برای خزش هوشمندانه تر صفحات توسط گوگل استفاده کنید.

نقشه سایت شما در کمک به یافته شدن صفحات وبسایت توسط خزنده موتور جستجوی گوگل نقش بسیار مهمی ایفا می کند و در صورتی که ساختار لینکدهی داخلی خیلی قدرتمند نباشد ابزاری حیاتی محسوب می شود.

استفاده از تگ های nofollow

به خاطر داشته باشید که خزنده موتور جستجو از صفحه ای به صفحه دیگر با دنبال کردن لینک ها حرکت می کند. بهرحال، می توانید با افزودن rel=nofollow به خزنده بگویید که آن لینک ها را دنبال نکند. وقتیکه موتور جستجو با لینک nofollow روبرو می شود آنها را نادیده می گیرد.

برای nofollow کردن یک لینک دو راه در پیش دارید:

- تگ متا: اگر میخواهید که موتورهای جستجو لینکی را در صفحه ای دنبال نکرده و نخزند، به تگ متای robots مقدار nofollow را بیافزایید.

<meta name="robots” content=”nofollow”>

- تگهای Anchor: اگر می خواهید لینک مشخصی را nofollow کنید، ویژگی rel=nofollow را به تگ واقعی لینک بیافزایید به شکل زیر:

<a href="www.example.com” rel=”nofollow>anchor text</a>

با این روش خزنده های موتور جستجو آن لینک را دنبال نمی کنند اما هنوز دیگر لینک های داخل صفحه را دنبال می کنند.

با استفاده از ویژگی rel=nofollow در تگ های لینک دیگر اعتباری به صفحه مقصد انتقال داده نمی شود.

در هر دوی مثال ها (تگ متا یا تگ Anchor)، در صورتیکه لینک دیگری به آن صفحه اشاره کند، نشانی وب مقصد هنوز امکان خزیده شدن و ایندکس شدن دارد.

یافتن خطاهای خزش

خطاهای خزش زمانی رخ می دهند که گوگل تلاش می کند صفحه ای را فرابخواند اما قادر به دسترسی به آن صفحه به دلایلی نیست. خطاهای خزش در به گستردگی یک وبسایت امکان رخ داده شدن دارند.

گزارش پوشش ایندکس در Google Search Console صفحاتی که گوگل در مواجهه با آنها با خطا مواجه می شود و به علاوه مسایلی که گوگل را از ایندکس صحیح صفحات باز میدارد را نشان می دهد.

دیدگاهتان را بنویسید